♦ El lenguaje labial es un método eficaz de comunicación en off en la vida diaria de personas con lesiones de las cuerdas vocales y lesiones laríngeas y linguales sin ocupar las manos. La recopilación e interpretación del lenguaje labial es un desafío. Aquí, proponemos el concepto de un novedoso sistema de decodificación de lenguaje de labios con sensores triboeléctricos autoalimentados, de bajo costo, de contacto y flexibles y un modelo de red neuronal recurrente dilatada bien entrenado basado en el aprendizaje de prototipos.

El principio estructural y las propiedades eléctricas de los sensores flexibles se miden y analizan. Se recopilan y comparan los movimientos de labios para vocales, palabras, frases, habla silenciosa y habla de voz seleccionadas. El modelo de aprendizaje prototipo alcanza una precisión de prueba del 94,5% en el entrenamiento de 20 clases con 100 muestras cada una. Las aplicaciones, como el reconocimiento de identidad para desbloquear una puerta, el control direccional de un coche de juguete y la conversión del movimiento de los labios al habla funcionan bien y demuestran una gran viabilidad y potencial. Nuestro trabajo presenta una forma prometedora de ayudar a las personas que carecen de voz a vivir una vida conveniente con una comunicación sin barreras y aumentar su felicidad, enriquece la diversidad de los sistemas de traducción de lenguaje de labios y tendrá un valor potencial en muchas aplicaciones.

Introducción

Los humanos pueden usar el lenguaje de los labios para comunicarse sin señales acústicas audibles generadas por el hablante. El lenguaje labial se puede usar en los siguientes escenarios típicos: personas que se han sometido a una laringectomía solo pronuncian palabras en lugar de pronunciarlas; conversaciones encubiertas que ocurren en ocasiones públicas; y el proceso del habla con interferencia en un entorno con mucho ruido de fondo. Sin embargo, el lenguaje de los labios es notoriamente difícil de dominar para el público, aunque es fácil de usar para los oradores. La mayoría de las personas solo pueden entender unas pocas palabras leyendo los labios. Decodificar el lenguaje de los labios de manera fácil y directa para el público es un desafío valioso. lenguaje de señas 1es otro método ampliamente utilizado para comunicaciones inaudibles a través de la visión, especialmente para personas con discapacidad auditiva. Se han realizado muchos estudios en lengua de signos 2 , 3 , 4 , 5 . Sin embargo, el lenguaje de labios tiene algunas ventajas sobre el lenguaje de señas, como que el lenguaje de labios libera las manos al hablar en comparación con el lenguaje de señas; el lenguaje de los labios utiliza el proceso del habla humana existente, mientras que dominar el lenguaje de señas requiere que uno aprenda una nueva norma desde el principio; y el lenguaje de labios tiene más diversidad semántica que el lenguaje de señas.

Los investigadores han realizado muchos estudios excelentes sobre el reconocimiento del lenguaje labial 6 , 7 . Las interfaces de voz silenciosa (SSI) 8 , 9 son sistemas que permiten hablar en escenarios inaudibles, incluidas las soluciones basadas en imanes 10 , 11 , 12 , soluciones basadas en visión 13 , 14 , solución basada en ultrasonido 15 , solución basada en acústica inaudible 16 y superficie soluciones basadas en electromiografía (sEMG) 17 , 18 . Con la mejora del aprendizaje automático y el aprendizaje profundo de rápido desarrollo en los últimos años 19 , 20, 21 , 22 , 23 , muchos trabajos han logrado tasas de reconocimiento más altas que los algoritmos tradicionales. Sin embargo, los métodos visuales sin contacto sufren la interferencia de los ángulos faciales, la intensidad de la luz, el movimiento de la cabeza y el bloqueo de objetos. Cuando la boca de un orador está cubierta por una máscara opaca, como es el caso de una epidemia de enfermedades infecciosas respiratorias (actualmente, la pandemia de la enfermedad por coronavirus 2019 (COVID-19)), las soluciones basadas en la visión fallan. El lenguaje de los labios se demuestra mediante una serie de formas de la boca 13 , 14, también conocido como el movimiento de los músculos esenciales de la boca. Los sensores no invasivos y de contacto que capturan el movimiento de los músculos son inmunes a los problemas de las soluciones basadas en la visión mencionadas anteriormente, que es una forma prometedora de adquirir datos del movimiento muscular.

Recientemente, los nanogeneradores triboeléctricos (TENG) 24 , 25 , 26 han atraído una atención cada vez mayor en todo el mundo. Los TENG basados en la electrificación de carga (CE) y la inducción electrostática convierten energía mecánica diminuta en electricidad y recolectan energía mecánica dispersa 27 , 28 . Los sensores 29 , 30 , 31 basados en TENG son de bajo costo, autoalimentados y generan señales eléctricas sin una fuente de alimentación adicional. Las características autoalimentadas ayudan a simplificar la estructura del circuito para la adquisición de datos del sensor. Estudios de sensores basados en TENG en detección de movimiento humano 32 , 33 , 34, interacción humano-computadora 35 , 36 , 37 , 38 , 39 , 40 , respiratoria 41 , vibración 42 y sonido 43 , 44 detección, táctil 45 , 46 y detección de presión 47 , 48 y dispositivos de detección portátiles han sido reportados abiertamente.

En este artículo, proponemos un novedoso sistema de decodificación del lenguaje de los labios (LLDS) para capturar los movimientos de los músculos de la boca con la ayuda de sensores flexibles, de bajo costo y autoalimentados y para reconocer señales con un clasificador de aprendizaje profundo. Los sensores autoalimentados colocados en la unión de los músculos de la boca están fabricados con películas de polímero flexibles para mejorar la sensación de la piel en la boca. Se adopta un modelo de red neuronal recurrente dilatada basado en el aprendizaje de prototipos para hacer frente a los desafíos de la diversidad de señales y muestras pequeñas personalizadas y se alcanza una precisión de prueba del 94,5 %. Se elige una máscara para ayudar al posicionamiento y fijación de los sensores, lo que aumenta la privacidad y la confidencialidad e interrumpe la transmisión de enfermedades infecciosas respiratorias. Este enfoque abre una nueva posibilidad para traducir el movimiento de los labios en voz o texto de manera directa y conveniente al capturar los movimientos musculares que brindan asistencia a las personas con falta de voz con pocos recursos ocupados. Este trabajo presenta una forma prometedora de ayudar a las personas con trastornos del habla a vivir una vida feliz con una comunicación sin barreras y enriquecerá la diversidad de los sistemas de traducción de lenguaje de labios en interfaces hombre-máquina e interfaces de voz silenciosa.

Este artículo está organizado de la siguiente manera: se describen en detalle la estructura y los componentes del LLDS y su flujo de trabajo, la estructura y el mecanismo de los sensores triboeléctricos colocados alrededor de la boca. Se investigan cuidadosamente las características fundamentales de los sensores triboeléctricos, como voltaje de circuito abierto, corriente de cortocircuito, conexión en serie-paralelo, curva de carga y durabilidad, a diferentes fuerzas y frecuencias. Las señales de movimiento de labios para palabras típicas se recopilan y comparan con el sonido sincronizado. Se compara y analiza el impacto de la velocidad del habla y el patrón de movimiento de los labios en las señales de los labios, las señales del habla silenciosa y el habla sonora. El tiempo requerido para el movimiento de la boca antes de los sonidos escuchados se cuenta en palabras específicas. Las señales de los labios se muestrean en un grupo de palabras específico para entrenar con un modelo de aprendizaje automático (ML). Las aplicaciones compatibles con LLDS, como el reconocimiento de identidad para desbloquear una puerta y el control direccional del movimiento de un coche de juguete, funcionan bien y demuestran la factibilidad potencial de mejorar la comunicación de las personas con barreras del habla con lenguaje de labios con la ayuda de sensores triboeléctricos.

Resultados

Diseño del sistema de decodificación del lenguaje labial y de los sensores triboeléctricos

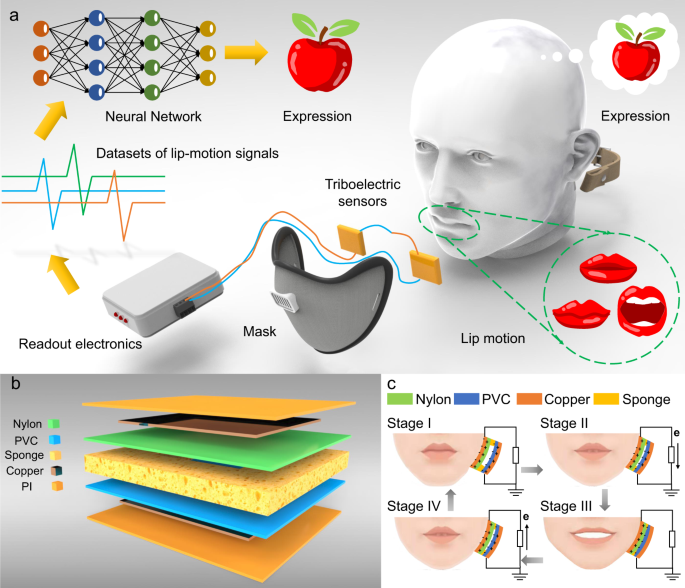

Aquí, proponemos el concepto del sistema de decodificación del lenguaje labial (LLDS) respaldado por sensores triboeléctricos flexibles para capturar señales y usar un clasificador asistido por aprendizaje profundo para traducir el lenguaje labial, como se muestra en la Fig. 1a. El sistema está compuesto por sensores triboeléctricos, máscaras de fijación, electrónica de lectura y clasificadores de redes neuronales. Se colocan sensores triboeléctricos flexibles en la unión del orbicularis oris, depressor anguli oris, risorius, zygomaticus y buccinator para capturar los movimientos musculares. Uno puede tomar el proceso de una persona que dice la palabra ‘manzana’ como ejemplo. Cuando habla, el sensor triboeléctrico detecta los movimientos de los músculos de los labios y genera una serie de señales eléctricas. El equipo electrónico relevante lee las señales eléctricas y realiza el procesamiento de rutina. Finalmente, las señales debidas a los movimientos de los músculos de los labios se reconocen tras la transferencia a la red neuronal entrenada, y la información reconocida se transmite mediante sonido o texto en una pantalla. Se utiliza una máscara para ayudar a ubicar y fijar los sensores triboeléctricos en posiciones específicas correspondientes a los músculos de la boca relevantes. Tanto la máscara como la esponja ayudan a proporcionar pretensión para ajustar la amplitud de las señales.

a Ilustración esquemática del sistema de decodificación del lenguaje de los labios y sus componentes, incluidos los sensores triboeléctricos, el procesamiento de señales y los clasificadores de aprendizaje profundo. b Esquema de estructura del sensor triboeléctrico flexible. c Diagrama esquemático de cuatro etapas de transferencia de carga en un ciclo de apertura y cierre de una boca. El proceso de apertura de la boca empuja el sensor y el proceso de cierre de la boca libera el sensor, lo que da como resultado el flujo de corriente en direcciones opuestas.

El esquema de estructura para el sensor triboeléctrico se muestra en la Fig. 1b. Este es un modo típico de separación de contactos para TENG con estructuras de doble electrodo. La esponja en el medio del sensor recupera su forma cuando desaparece la compresión. Se utiliza un orificio rectangular cortado en el centro de la esponja para completar la transferencia de carga a través del contacto de los materiales. Las películas de cloruro de polivinilo (PVC) y poliamida (nylon) se distribuyen en ambos lados de la esponja y se cubren con películas de cobre. El sensor está empaquetado con una película de poliimida (PI) para mantener la piel humana, el sudor y las escamas de la piel lejos de los electrodos de cobre. Los materiales utilizados para construir el sensor son de bajo costo y de fácil obtención. Los componentes del sensor son películas plásticas delgadas, esponjas y láminas delgadas de cobre, que son flexibles para adaptarse a la deformación de los músculos faciales.

El mecanismo de trabajo de generación de señal eléctrica para el sensor triboeléctrico se muestra en la Fig. 1c. Las cargas eléctricas se generan por contacto y movimiento separado de materiales; El PVC gana electrones y el nailon los pierde. El proceso de transferencia de carga en el ciclo de apertura y cierre de una boca (presionar y soltar) se divide en cuatro etapas. No hay cambios de carga durante la etapa I cuando la boca permanece cerrada, y las películas de nailon y PVC inducen cargas positivas y negativas correspondientes en los electrodos de cobre, respectivamente. Cuando la boca se abre, los músculos presionan el sensor en la etapa II y las películas de nailon se acercan al PVC. Las cargas inducidas en los electrodos de cobre correspondientes disminuyen y la corriente fluye desde el electrodo del lado de PVC al electrodo del lado de nailon. Cuando la apertura de la boca alcanza su máximo en la etapa III, la corriente se reduce a cero y las cargas inducidas en los electrodos se reducen a casi cero. En el estadio IV de cierre de la boca, cuando la película de nailon se aleja del PVC, las cargas inducidas en el electrodo de cobre aumentan y la corriente fluye desde el electrodo del lado de nailon al electrodo del lado de PVC. La esponja cambia a su forma original y entra de nuevo en la etapa I, completando un ciclo completo de apertura y cierre de la boca. COMSOL simula las distribuciones del campo eléctrico para el sensor en diferentes estados de liberación de presión, como se muestra en la Fig. 1 , y de izquierda a derecha corresponden a las etapas I, II(IV) y III en la Fig. 1c , respectivamente.

Características fundamentales de los sensores triboeléctricos

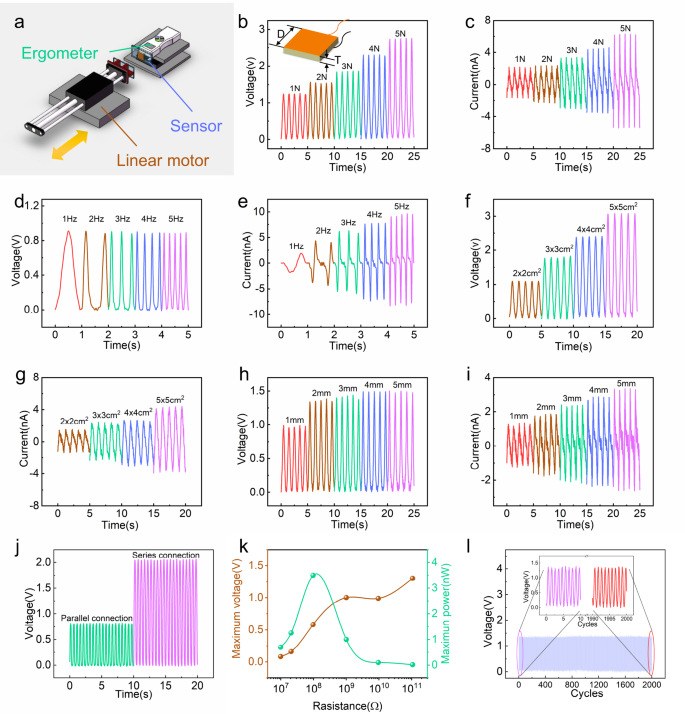

Las características eléctricas del sensor triboeléctrico son cruciales para la lectura de labios. Se investigaron las influencias de parámetros como la fuerza, la frecuencia, el tamaño del sensor, la estructura en serie y en paralelo en las señales eléctricas. Se estudiaron las tensiones y potencias de salida con diversas resistencias de carga externa y duraciones. La plataforma experimental que incluye el motor lineal y el ergómetro se muestra en la Fig. 2a . El sensor fijado en el ergómetro era empujado periódicamente por un motor lineal a una frecuencia dada. Las fuerzas de empuje se variaron ajustando la separación. El sensor es un cuadrado con longitud D y espesor T , como se muestra en el recuadro de la Fig. 2b. Las señales eléctricas generadas por varios materiales (Papel/ Tereftalato de polietileno (PET)/ Politetrafluoroetileno (PTFE)/ Poliimida (PI)/ Cloruro de polivinilo (PVC)/ Etileno propileno fluorado (FEP)) contacto de nylon se registraron utilizando un 20 × 20 × Sensor de 5 mm 3 con una fuerza de 5 N a una frecuencia de 2 Hz, como se muestra en la Fig. 2a complementaria . Tanto el PVC como el FEP muestran un mejor rendimiento de salida con nailon, y se elige el PVC por su mejor dureza. Las curvas de voltaje de circuito abierto y corriente de cortocircuito se muestran en la figura complementaria 2b, c .

una Plataforma con fuerza de presión y frecuencia ajustables compuesta por un motor lineal, un ergómetro y un sensor. b , c La tensión de circuito abierto y la corriente de cortocircuito obtenidas al presionar el sensor a una frecuencia de 1 Hz con diferentes fuerzas (de 1 N a 5 N). Recuadro: diagrama esquemático del tamaño del sensor. d , e La tensión de circuito abierto y la salida de corriente de cortocircuito del sensor a la frecuencia de presión (de 1 Hz a 5 Hz) con una fuerza de 5 N. f , g La tensión de circuito abierto y la salida de corriente de cortocircuito obtenida de sensores con diferentes áreas a una frecuencia de 1 Hz con una fuerza de 5 N. h , iEl voltaje de circuito abierto y la salida de corriente de cortocircuito obtenida de sensores con diferentes espesores a una frecuencia de 1 Hz con una fuerza de 5 N. j El voltaje de circuito abierto para dos sensores colocados en serie y en paralelo. k Las curvas de máxima potencia de salida y máxima tensión del sensor triboeléctrico utilizado como fuente de alimentación con diferentes resistencias de carga externa (rango de 10 7 a 10 11 Ω) con una fuerza de 5 N a una frecuencia de 2 Hz. l Ensayo de durabilidad mecánica de hasta 2000 ciclos de prensa. Recuadro: las señales de tensión generadas durante los 10 s iniciales y los 10 s finales.

Las señales eléctricas generadas con una fuerza variable a diferentes frecuencias se muestran en la Fig. 2b–e . Los voltajes y corrientes obtenidos utilizando una estructura de 20 × 20 × 5 mm 3 con fuerzas variables (de 1 N a 5 N) a 1 Hz se muestran en la Fig. 2b, c . El sensor es sensible a la presión por encima de 1 N y la sensibilidad es de 0,376 V/N. Los voltajes y corrientes obtenidos utilizando una estructura de 20 × 20 × 5 mm 3 con fuerzas de 5 N a varias frecuencias (de 1 Hz a 5 Hz) se muestran en la Fig. 2d, e . La corriente aumenta al aumentar la frecuencia, de 1,88 nA a 9,66 nA, mientras que la señal de voltaje de salida básicamente permanece igual y la fluctuación de voltaje es <0,02 V (0,89–0,91 V).

Los voltajes y corrientes obtenidos con fuerzas de 5 N a 1 Hz usando una estructura D × D × 2 mm 3 (longitud variable D de 20 mm a 50 mm) se muestran en la Fig. 2f, g. El voltaje y la corriente de salida aumentan con el área, el voltaje aumenta de 1,10 V a 3,08 V y la corriente aumenta de 1,52 nA a 4,39 nA. Cuanto mayor sea el área de contacto, más cargas se generan y se transfieren entre los electrodos, lo que da como resultado una mayor salida de corriente. El voltaje aumenta con el área de contacto debido a la mayor fricción producida por la estructura del sensor. Para una mejor salida, se debe aumentar el área del sensor. Sin embargo, el área del sensor está restringida por el tamaño del músculo que se está monitoreando. Los voltajes y corrientes obtenidos con una fuerza de 5 N a 1 Hz utilizando una estructura de 20 × 20 × T mm 3 (espesor variable T de 1 mm a 5 mm) se muestran en la Fig. 2h, i. El voltaje y la corriente de salida aumentan con el espesor hasta que el espesor T alcanza los 2 mm, y luego el voltaje y la corriente de salida apenas cambian. La inducción electrostática de la carga disminuye hiperbólicamente al aumentar el espacio; cuando el espesor alcanza los 2 mm, la inducción electrostática se debilita, con solo un pequeño aumento de carga en los electrodos.

La conexión en serie y en paralelo de los dos sensores se investiga en la Fig. 2j . Las señales de voltaje en serie son más fuertes que las de paralelo debido a la mayor área en la conexión en serie. Las señales de corriente en serie y en paralelo se muestran en la Fig. 2d complementaria . Las curvas de potencia y voltaje con diferentes resistencias de carga externas se muestran en la Fig. 2k . La potencia de salida máxima del sensor es de 3,50 nW con una resistencia externa de 97,1 MΩ, lo que indica que la resistencia interna del sensor es de ~100 MΩ. La curva de corriente con una carga externa se muestra en la Fig. 2e complementaria . La duración de la señal del sensor cambia con el número de pulsaciones, como se muestra en la Fig. 2l. Bajo el prensado periódico de una fuerza de 5 N a 2 Hz, la tensión de salida del sensor de 20 × 20 × 2 mm 3 se atenúa básicamente menos (de 1,40 V al principio a 1,38 V al final) después de 2000 ciclos de prensado continuo , lo que indica una buena duración de la señal de voltaje.

El impacto del sudor artificial (sudor artificial, PH5.5, CF-001, Chuangfeng Co., LTD) en el rendimiento del sensor se muestra en la figura complementaria 2f, g . La tensión de circuito abierto y la corriente de cortocircuito se miden con 0–4 gotas (0,0157 ml/gota). El resultado muestra que el sudor artificial tiene poco efecto sobre el rendimiento de salida eléctrica del sensor. La comparación de este sensor triboeléctrico con sensores capacitivos, piezoresistivos y piezoeléctricos se analiza en la nota complementaria 3 .

Señales eléctricas generadas por el movimiento de la boca y su comparación con señales sonoras

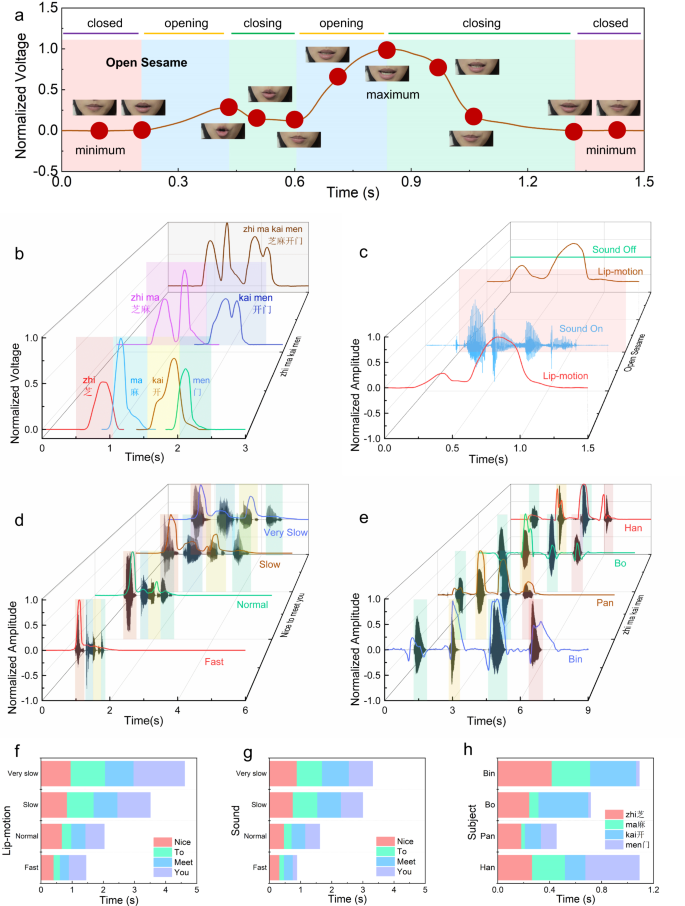

La señal de la forma de la boca se detectó durante la vocalización normal con el sensor fabricado, como se muestra en la Fig. 3 . Se observan principalmente dos tipos de señales: una es la señal de forma de onda correspondiente a la pronunciación de las vocales, y la otra es la señal de forma de onda para palabras y frases. Para resaltar la diferencia en las formas de onda de la señal, la interferencia de amplitud se elimina mediante la normalización.

a En una secuencia de habla típica («Ábrete sésamo»), la forma de la boca se sincroniza con la señal y las regiones separadas por el estado de la boca se indican como cerrada, abriéndose y cerrándose. b Las señales de movimiento de los labios combinadas y descompuestas para “Zhi”, “Ma”, “Kai”, “Men”, “Zhi Ma”, “Kai Men” y “Zhi Ma Kai Men”. c Las señales de movimiento de los labios para hablar en silencio y con voz siguen siendo las mismas, y los sonidos se graban sincrónicamente cuando se habla “Open Sesame”. d Las señales de sonido y movimiento de los labios se recopilan simultáneamente a cuatro velocidades de lectura «Encantado de conocerte». e Señales de sonido y movimiento de labios recopiladas simultáneamente cuando cuatro participantes (Han, Bo, Pan y Bin) leen “Zhi Ma Kai Men”. FEl tiempo utilizado para las señales de movimiento de los labios para cada palabra en «Encantado de conocerte» a cuatro velocidades de lectura diferentes. g El tiempo utilizado para las señales de sonido de cada palabra en “Encantado de conocerte” a cuatro velocidades de lectura diferentes. h Las estadísticas de tiempo para las señales de movimiento de los labios antes de las señales de sonido para cada palabra en “Zhi Ma Kai Men” pronunciada por cuatro participantes.

En la Fig. 3 se muestra en detalle la relación correspondiente entre las señales del sensor y las formas de la boca . Tomando como ejemplo hablar «Open Sesame», las señales de movimiento de los labios y el video se recopilan simultáneamente durante 1,5 s. Las señales de movimiento de los labios registradas se normalizan. Tres tipos de formas típicas en la curva de la señal corresponden a los estados de boca cerrada, abierta y cerrada. La forma de la curva de la señal divide la región de tiempo en ocho partes, incluidas dos partes con la boca cerrada, dos partes con la boca abierta y cuatro partes con la boca cerrada. Hay dos picos en la curva: «Abierto» corresponde a un pico pequeño y «sésamo» corresponde a un pico grande. Las vocales tienen una mayor influencia en los movimientos de la boca que las consonantes, y las señales de 12 vocales y las formas de boca correspondientes se recopilan en la figura complementaria 5a-l. Las señales de movimiento de los labios al pronunciar / a: / con diferentes tamaños de apertura de la boca se muestran en la Fig. 6a complementaria .

Para comprender las diferencias y similitudes de la pronunciación entre frase y palabras en la frase, se capturaron las señales de labios correspondientes a la pronunciación de palabras y frase, como se muestra en la Fig. 3b . Tomemos como ejemplo la frase china “zhi ma kai men”. Las frases chinas se pueden desarmar en combinaciones Hanzi, al igual que las señales capturadas. Hay 3 filas: las filas delantera, media y trasera correspondientes a diferentes combinaciones en la Fig. 3b. La fila de atrás muestra las señales de movimiento de labios consecutivas para la frase en chino «zhi ma kai men», mientras que la fila del medio muestra las señales de movimiento de labios para la combinación de frases en chino: «zhi ma» y «kai men» una por una. y la primera fila muestra señales de movimiento de labios para los caracteres Hanzi: «zhi», «ma», «kai» y «men» uno por uno. Las formas de onda de la señal en las filas delantera y central se ensamblan igual que la forma de onda de la señal en la fila trasera. Para expresar información más rápido, los humanos omiten automáticamente algunas partes de la pronunciación, y esta característica se puede observar claramente en la diferencia de señal en la Fig. 3b. La señal del labio correspondiente a una sola palabra en la frase es más corta y se mejora la eficacia de la duración de la señal. Para “zhi ma kai men”, la eficiencia de las señales continuas en la última fila (1,648 s) es un 31,3 % más alta que la de las combinaciones de señales de un solo Hanzi en la primera fila (total 2,398 s). Para “sésamo abierto”, se necesitan 1,10 s para leer de forma continua la frase y un total de 1,286 s para leer dos palabras por separado, lo que aumenta la eficiencia en un 14,5 %. Se indican más detalles en la Fig. 6b complementaria . El proceso de manipulación de datos se demuestra en la nota complementaria 6 .

El sonido y el movimiento de los labios se relacionan naturalmente al hablar. Las señales de movimiento de los labios y las señales de sonido se recopilan y comparan sincrónicamente, y se estudia la relación entre las señales. El filtrado de paso bajo se utiliza para eliminar las señales de interferencia de frecuencia industrial con una frecuencia de corte de 20 Hz. Para eliminar la interferencia en las amplitudes de forma de onda causada por diferentes condiciones, las amplitudes de las señales se normalizan, como se muestra en la Fig. 3c–e .

Las señales de movimiento de los labios y las señales de sonido para «sésamo abierto» se recopilaron en los modos sonido sobre los labios y sonido fuera de los labios, que se distinguen por una superficie gris, como se muestra en la Fig. 3c . El modo de sonido sobre los labios aparece en la parte delantera y el modo de sonido fuera de los labios aparece en la parte posterior. Las señales de movimiento de los labios tienen buena consistencia en los modos de sonido activado y desactivado. La vocalización no tuerce la forma de onda de la señal del movimiento de los labios. Este fenómeno es útil para que las personas con lesiones en la garganta se comuniquen con el lenguaje labial. Además, el volumen de datos para las señales de movimiento de los labios (12 KB) es mucho menor que el de las señales de sonido (576 KB), solo 1/48, lo que significa que la adquisición, el almacenamiento y la transmisión de datos de las señales de movimiento de los labios consumen menos recursos.

Se estudia la influencia de la velocidad del habla en las señales de movimiento de los labios. La figura 3d muestra la diferencia entre la señal de movimiento de los labios y la señal de sonido de la frase «encantado de conocerte» recopilada simultáneamente para una persona a diferentes velocidades del habla. Los puntos inicial y final del sonido son fáciles de identificar y se utilizan para identificar la longitud de la frase, y se obtienen las duraciones de la frase, como se muestra en la Fig. 3d . Hay cuatro duraciones basadas en el sonido: muy lento (3,988 s), lento (3,383 s), normal (1,636 s) y rápido (0,857 s). Las formas de onda de la señal son básicamente similares a diferentes velocidades del habla, pero cambia la amplitud relativa de los movimientos de los labios al final de la frase. Las amplitudes relativas de la señal «encuentro» se muestran en la Fig. 3d, y los valores máximos normalizados son 0,6725, 0,4922, 0,3170 y 0,0879.

La figura 3e muestra la diferencia en el movimiento de los labios y las señales de sonido recopiladas de cuatro personas (Pan, Bo, Bin y Han) cuando pronuncian la frase «zhi ma kai men». Ambas señales de movimiento de labios para Bo y Bin muestran leves depresiones hacia abajo al principio de cada palabra, pero las señales para Pan y Han no muestran esta característica. Además, los cuatro participantes mostraron diferencias obvias en la velocidad del habla. Las diferencias en estas curvas de señal se deben a los hábitos únicos de habla y pronunciación formados por cada pueblo durante muchos años. Los diferentes hábitos de estiramiento muscular conducen a una variación individual significativa en los detalles de las señales de movimiento de los labios de las personas, lo que indica el potencial para su uso en aplicaciones de identificación.

La duración de la señal de movimiento de labios es más larga que la duración de la señal de sonido, como se muestra en la Fig. 3f, g. Las duraciones de las frases para las señales de sonido representan del 60,8 % al 85,4 % de las duraciones de las señales de movimiento de los labios. Cada palabra exhibe diferentes proporciones a diferentes velocidades del habla para lectura continua y omisión de sílabas. La proporción de palabras tiene una fuerte relación con el número de sílabas. Las proporciones de palabras polisilábicas aumentan con la velocidad del habla. La proporción de señales sonoras “agradables” aumenta del 26,5 % al 36,2 %, y la proporción de señales de labios aumenta del 20,7 % al 28,1 %; la proporción de sonidos de «conocer» aumenta del 26,0 % al 32,3 %, y la proporción de señales labiales cambia del 19,8 % al 19,9 %. Mientras tanto, la proporción de palabras de una sílaba disminuye con la velocidad del habla. La proporción de señales sonoras “a” disminuye de 24,4% a 16,8%, y las señales de labios disminuyen de 23,9% a 14,0%; la proporción de señales de sonido “tú” disminuye del 23,1 % al 14,8 %, y las señales de los labios cambian del 35,5 % al 38,0 %. Las palabras de una sílaba están mucho más comprimidas que las palabras polisilábicas en el habla rápida, tanto en el sonido como en las señales de los labios.

La señal de movimiento de labios comienza antes que la señal de sonido porque las personas primero abren la boca y luego hablan. Figura 3hcuenta los avances de tiempo para la señal de movimiento de los labios en relación con la señal de sonido cuando cuatro personas (Pan, Bo, Bin y Han) dicen la frase “zhi ma kai men”, y el avance de tiempo total es ~18–417 ms. Hay variaciones individuales en el avance del tiempo debido a los hábitos de los hablantes. La primera sílaba de “zhi” y “kai” son /zh/ y /k/, respectivamente, que son sonidos abiertos, por lo que el avance de tiempo es mayor, entre 124 y 417 ms; la primera sílaba de “ma” y “men” /m/ es un sonido nasal, que no requiere la apertura de la boca, y el avance de tiempo es pequeño, 18-295 ms, como muestran los datos obtenidos para Pan, Bo y Bin. Han tiene movimientos de labios obvios cuando pronuncia /m/, lo que lleva a un mayor avance de tiempo, como se muestra en los datos de Han.

Clasificador de redes neuronales entrenado para reconocimiento de lenguaje de labios

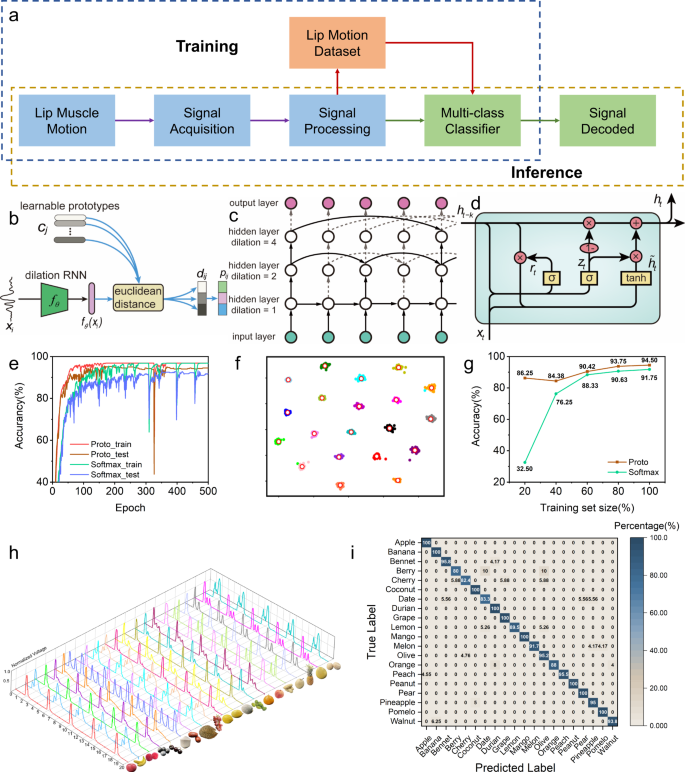

Un escenario típico del lenguaje de labios es ayudar a las personas con discapacidad del habla a comunicarse sin barreras. Para las personas con problemas del habla, un sistema de reconocimiento del lenguaje de los labios les ayuda a interpretar rápidamente el movimiento de los labios a través de algoritmos y finalmente lograr una comunicación sin barreras con personas normales a través de medios de sonido y luz. Teniendo en cuenta la frecuencia y complejidad de la comunicación diaria y la distinguibilidad de las señales de movimiento de los labios detectadas por el sensor, es necesario utilizar algoritmos de aprendizaje profundo para lograr el reconocimiento inteligente del lenguaje de los labios. LLDS contiene dos procesos de flujo de datos: entrenamiento e inferencia, como se muestra en la Fig. 4a. En la etapa de entrenamiento, el conjunto de datos que consta de señales de movimiento de los labios se usa para entrenar el modelo de aprendizaje profundo. En la etapa de inferencia, el modelo entrenado decodifica nuevas señales para su reconocimiento. Sin embargo, los modelos de aprendizaje profundo suelen tener mucha necesidad de datos, lo que presenta un gran desafío para entrenar un modelo de alta precisión con muestras limitadas de movimiento de labios.

un flujo de proceso de datos asistido por aprendizaje profundo, que incluye un proceso de entrenamiento y de inferencia. b Diagrama esquemático de la estructura general del modelo de red neuronal recurrente dilatada basado en el aprendizaje de prototipos. c Diagrama de estructura del extractor de características en el modelo. d La unidad básica de la red neuronal recurrente dilatada GRU. e Las curvas de precisión de entrenamiento y prueba obtenidas durante el proceso de aprendizaje para la red neuronal recurrente dilatada basada en la capa de clasificación softmax y el aprendizaje del prototipo. f Visualización de las características bidimensionales de la red neuronal recurrente dilatada basada en el aprendizaje de prototipos. gramoComparación de la precisión de la prueba para dos modelos con diferentes tamaños de muestra. h Gráfica 3D de las señales de movimiento de labios generadas para 20 palabras habladas (fruta) en el conjunto de datos. i La matriz de confusión para señales de movimiento de labios para 20 palabras (frutas).

Para abordar el problema anterior, proponemos un modelo 49 de red neuronal recurrente dilatada (RNN dilatada) basado en un enfoque de aprendizaje prototipo 50 , y se muestran más detalles en la nota complementaria 7 . La Figura 4b ilustra el marco de nuestro método de reconocimiento de señales de labios en este estudio. Para cada categoría, el modelo aprende un prototipo en el espacio de características profundas. En la etapa de clasificación, las señales se clasifican por comparación de prototipos. Específicamente, la muestra de entrenamiento pasa por el extractor de características para obtener su representación en el espacio profundo de características. Calculando la distancia euclidiana entre el vector de características de la muestra y la categoría prototipos, se obtiene la categoría a la que pertenece. Figura 4cmuestra un diagrama esquemático de la estructura del extractor de características en el modelo. El extractor de características es una red neuronal recurrente dilatada multicapa. La red neuronal recurrente ayuda a capturar dependencias a largo plazo en la secuencia. El mecanismo dilatado reduce efectivamente la cantidad de parámetros del modelo y mejora significativamente la eficiencia del entrenamiento. En particular, la unidad recurrente controlada (GRU) 51 se elige como la unidad básica de la red neuronal recurrente, que incluye la puerta de actualización y la puerta de reinicio utilizadas para capturar las dependencias en la secuencia. La estructura se muestra en la Fig. 4d . El proceso de recopilación de datos se describe en la nota complementaria 8 . El preprocesamiento de datos para el aprendizaje automático se demuestra en la nota complementaria 9.

Para facilitar la comparación, utilizamos la capa de clasificación softmax y el aprendizaje de prototipos en RNN dilatada para clasificar las señales recopiladas. Los datos experimentales contienen 20 categorías (se seleccionan 20 nombres de frutas en la Fig. 7a–t complementaria , y las señales de movimiento de los labios se recopilan en la Fig. 8a–t complementaria ). Cada categoría contiene 100 muestras de entrenamiento, de las cuales 80 se usan para entrenamiento y 20 para pruebas. Se adopta una red neuronal recurrente dilatada de 4 capas con 50 neuronas en cada capa. Figura 4emuestra la precisión del entrenamiento y la precisión de las pruebas para el proceso de aprendizaje de los dos modelos. Después de entrenar durante 500 épocas, la precisión de la prueba del RNN dilatado con la capa de clasificación softmax alcanza el 91,75 %, y la precisión de la prueba del aprendizaje del prototipo alcanza el 94,50 %, que es significativamente mayor que la del modelo basado en la clasificación softmax. capa. Además, se puede observar a partir de la curva de precisión en el proceso de entrenamiento que el modelo basado en el aprendizaje de prototipos converge más rápido que el modelo de la capa de clasificación softmax.

El espacio de características 2D se selecciona para visualizar la distribución de muestras en el espacio de características. La Figura 4f muestra la distribución de muestras de entrenamiento en el espacio de características para los modelos de aprendizaje prototipo (para la distribución de muestras de entrenamiento en el modelo de capa de clasificación softmax, consulte la Fig. 9a complementaria ). Diferentes colores representan diferentes categorías. La distribución de muestras en el espacio de características con el modelo de aprendizaje prototipo muestra una mayor separabilidad entre clases y compacidad intraclase que el modelo softmax.

En particular, se llevaron a cabo experimentos de clasificación de muestras pequeñas. Las curvas de precisión de la prueba para los modelos basados en el aprendizaje de prototipos y softmax para un número de muestra de entrenamiento que disminuyó gradualmente al 100/80/60/40/20% del número original se muestran en la figura complementaria 9b, c . Figura 4gcompara la precisión de los dos modelos con diferentes tamaños de muestra. El modelo basado en el aprendizaje de prototipos tiene un rendimiento significativamente mejor en la precisión de la prueba que el modelo softmax cuando hay menos muestras de entrenamiento. Cuando los datos de entrenamiento son del 20%, el modelo basado en prototipo de aprendizaje tiene una precisión de prueba de 85,23%, mientras que el modelo basado en softmax solo tiene una precisión de prueba de 31,46%; el primero es ~2,7 veces el segundo. El impacto de los hiperparámetros, incluida la cantidad de capas y neuronas en cada capa, en la precisión de la prueba se muestra en la figura complementaria 9d-f .

La figura 4h muestra las diferentes señales de movimiento de labios para 20 palabras. Cada palabra repetida cinco veces en cada línea de señal de movimiento de labios brinda una buena repetibilidad, y la línea de señal interceptada dura 20 segundos. El movimiento de los labios para la mayoría de las palabras muestra formas de onda significativamente únicas, mientras que algunas palabras muestran formas de onda similares, como Berry y Olive. Las probabilidades de confusión detalladas para las señales de movimiento de labios de 20 palabras basadas en el aprendizaje de prototipos se muestran en la matriz de confusión en la Fig. 4i. Las señales mucho más cercanas tienen una mayor probabilidad de confusión. La precisión de reconocimiento total del modelo actual es del 95%, mientras que cada palabra tiene una precisión de reconocimiento diferente en la diagonal. El cuarenta y cinco por ciento de las palabras tienen una precisión de reconocimiento del 100 %, el 80 % de las palabras tienen una precisión >90 % y el 100 % de las palabras tienen una precisión >80 %. Ocurre cierta confusión; por ejemplo, con un 10% de probabilidad, Berry se reconoce como Date u Olive. Las palabras con señales de movimiento de labios similares se pueden buscar con la ayuda de una matriz de confusión y guiar la mejora adicional del sensor. Las probabilidades de confusión detalladas para señales de movimiento de labios de 20 palabras basadas en softmax se muestran en la figura complementaria 10a , y una comparación de las curvas de función de pérdida se muestra en la figura complementaria 10b .

Aplicaciones del sistema de decodificación del lenguaje labial

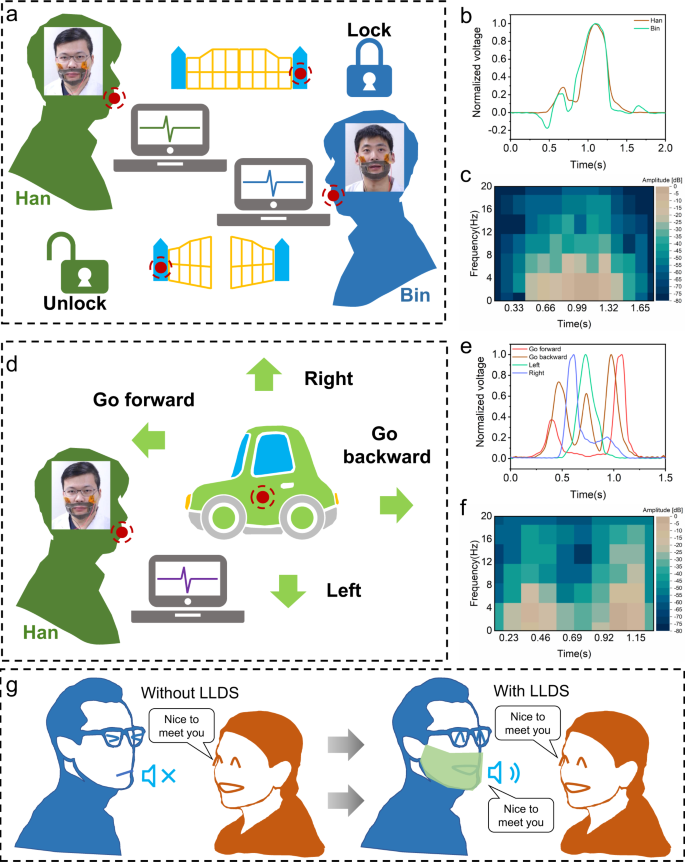

Las señales de movimiento de los labios detectadas por los sensores se recopilan y preparan para el desarrollo de aplicaciones, como la autenticación de identidad para desbloquear puertas y controlar la dirección del movimiento del automóvil mediante el movimiento de los labios y brindar asistencia con la comunicación para personas que carecen de voz.

La figura 5a muestra el proceso esquemático para desbloquear una puerta mediante el reconocimiento de la señal del movimiento de los labios. Cuando el anfitrión (Han) pronuncia la instrucción de desbloqueo («Abrir sésamo»), el sistema reconoce la señal de los labios del anfitrión y la puerta se abre; cuando el invitado (Bin) pronuncia la misma instrucción de desbloqueo, la identificación de la señal de movimiento de los labios falla y la puerta permanece cerrada. Esta aplicación demuestra la capacidad de verificación de la identidad personal mediante el reconocimiento del movimiento de los labios. Se comparan las señales de movimiento de los labios del anfitrión y el invitado en el dominio del tiempo (que se muestra en la Fig. 5b ) y en el dominio de la frecuencia (en la Fig. 11a complementaria ). Los gráficos de transformada de Fourier de tiempo corto (STFT) para las señales de movimiento de los labios de Han y Bin se comparan en la Fig. 5cy la Fig. 11b complementaria . La forma de onda de tensión normalizada y la amplitud de las señales de Han se distinguen claramente de las de Bin y pueden utilizarse como criterios de discriminación. Vea la Película Suplementaria 1 para el video.

un diagrama esquemático del desbloqueo de una puerta por movimiento de labios con verificación de identidad personal. b Una comparación de las señales de movimiento de los labios de los participantes (Han y Bin) en el dominio del tiempo. c Análisis de transformada de Fourier de tiempo corto (STFT) de las señales de movimiento de los labios de Han. d Diagrama esquemático del control de la dirección del movimiento de un coche de juguete mediante el movimiento de los labios. e Comparación de señales de movimiento de labios de Han en el dominio del tiempo. f Análisis STFT de las señales de movimiento de los labios para ‘Adelante’ de Han. g Diagrama esquemático de la comunicación de voz diaria para personas sin voz con y sin sistema de decodificación de lenguaje de labios (LLDS).

La Figura 5d muestra el proceso de aplicación para controlar la dirección del movimiento de un carro de juguete con reconocimiento de señales de movimiento de labios, lo que demuestra la capacidad de reconocimiento de movimiento de labios para distinguir instrucciones de una persona. Había cuatro instrucciones direccionales: «Ir hacia adelante», «Ir hacia atrás», «Izquierda» y «Derecha». La Figura 5e muestra las curvas en el dominio del tiempo para el movimiento de los labios de las instrucciones enviadas por Han para controlar las cuatro direcciones de movimiento de un automóvil. Las curvas de dominio de frecuencia correspondientes se muestran en la figura complementaria 11c. Hay algunas diferencias en las amplitudes de voltaje normalizadas para las cuatro instrucciones de Han. Las formas de onda de las cuatro instrucciones son significativamente diferentes. Los gráficos STFT para las instrucciones hacia adelante de Han se muestran en la Fig. 5f , y los gráficos para las instrucciones hacia atrás, izquierda y derecha se muestran en la Fig. 11d–f complementaria . Las señales de movimiento de los labios para las instrucciones de una persona muestran una diferencia y pueden reconocerse y usarse para controlar la dirección. Vea la Película complementaria 2 para ver el video.

La Figura 5g muestra un escenario posible para la comunicación de voz diaria con amigos para una persona que carece de voz con y sin LLDS, lo que demuestra la posibilidad de usar LLDS para ayudar a las personas sin voz a recuperar la capacidad de comunicación de voz diaria. Una persona que no tiene voz no puede responder a los saludos de sus amigos con voz natural. Sin embargo, con la ayuda de LLDS, esa persona puede responder a un amigo con movimientos de los labios, que se capturan, analizan, decodifican en expresiones específicas (palabras u oraciones) y se traducen en voz y texto. En esta aplicación, el participante (Han) pronuncia frases con la voz en off, LLDS captura las señales relacionadas con el movimiento de los labios, completa el reconocimiento e invoca la reproducción de voz. Ver película complementaria 3para el vídeo Con dicha tecnología, las personas que carecen de voz pueden disfrutar de la vida cotidiana sin barreras en la comunicación de voz, lo que ayuda a aumentar su felicidad y ofrece una gran comodidad en la conversación.

Discusión

En este estudio, propusimos e investigamos un sistema de interpretación del lenguaje de los labios basado en sensores triboeléctricos operados en modo de separación por contacto. Los sensores triboeléctricos se adhieren a los músculos de los labios y capturan el movimiento de los labios y transfieren las señales eléctricas medidas a un sistema de decodificación, que luego se traducen a un lenguaje de comunicación. Se probaron y analizaron los principios y las propiedades mecánicas y eléctricas del sensor TENG. Se recopilaron patrones de señales para vocales y palabras seleccionadas y se analizaron las características de las señales. Las señales del labio y del sonido se compararon simultáneamente, demostrando que el movimiento del labio para el habla silenciosa es igual al del habla sonora. Se analizó el impacto de diferentes parámetros, como la velocidad del habla y el patrón de movimiento de los labios, en las señales recopiladas. Se propone un modelo de red neuronal recurrente dilatada basado en el aprendizaje de prototipos y se emplea en el reconocimiento del lenguaje labial, el cual logra una precisión de prueba del 94,5% para el caso de 20 clasificaciones y 100 muestras por clasificación. Las aplicaciones basadas en el sistema de interpretación del lenguaje labial con sensores triboeléctricos, como el reconocimiento de identidad para abrir una puerta, el control direccional de un carro de juguete en movimiento y la traducción de voz, funcionan bien y muestran la viabilidad y el potencial para el reconocimiento del lenguaje labial. Esto enriquece las formas y los medios para ayudar a las personas con trastornos del habla a vivir una vida cómoda con una comunicación sin barreras. Este trabajo tiene un valor potencial en aplicaciones que involucran control de robots, verificación de identidad personal, interfaces hombre-máquina, asistencia para discapacitados, habla silenciosa, inteligencia, implementación de misiones antiterroristas,

Métodos

fabricación de sensores

La preparación de los sensores TENG se puede dividir en preparación y montaje de electrodos. En el sensor TENG, se utilizaron nailon y PVC como materiales de fricción y una lámina de cobre como material del electrodo. Se cortaron láminas cuadradas con una longitud lateral de 40 mm de las películas de nailon (0,08 mm) y PVC (0,08 mm) adquiridas. Una lámina de cobre cuadrada con una longitud lateral de 30 mm se unió al diafragma como electrodos. Sobre la lámina de cobre se soldaron alambres de cobre con un diámetro de 0,71 mm. Se utilizó esponja de poliuretano como material espaciador; Se cortó una esponja de poliuretano de 3,5 mm de espesor en un bloque cuadrado con una longitud lateral de 40 mm, y se cortó un bloque cuadrado con una longitud lateral de 20 mm en el medio para hacer un bloque espaciador de 10 mm de ancho en cada lado. Los dos electrodos se fijaron a ambos lados del espacio,

Fabricación de máscaras

La máscara se preparó con tela no tejida, con una estructura plegada en el medio y el área de los labios expuesta para minimizar el impacto en el habla normal. La máscara se fijó a la cara mediante tres bandas de goma en la parte superior, media e inferior. Se instalaron dos sensores triboeléctricos en las comisuras izquierda y derecha de la boca (correspondientes al músculo orbicularis oris) para captar las señales de movimiento del músculo orbicularis oris. Los dos sensores están conectados en serie para aumentar la amplitud de la señal.

Fabricación del hardware utilizado para el desbloqueo de puertas activado por movimiento de labios

Los modelos geométricos (Solidworks) de dos portones y marcos de portones se imprimieron en 3D utilizando materiales PLA. Las señales de movimiento de los labios recopiladas por la máscara se analizaron mediante software para obtener señales de control, y las señales de control se transfirieron a una microcomputadora de un solo chip a través de la conversión (módulo Wison CH340G USB a TTL) (versión de sistema pequeño STM32F103C8T6). Luego, se controló el mecanismo de dirección (SG90, mecanismo de dirección) para abrir la puerta.

Fabricación del hardware utilizado para el control remoto activado por movimiento de los labios de un coche de juguete.

Los módulos comprados se ensamblaron en el carro de juguete. El software analizó la señal del movimiento de los labios recopilada por la máscara para obtener la señal de control y se transmitió a un módulo Bluetooth en el automóvil (módulo serie Bluetooth Vision BT08B). La señal se transmitió a la placa principal (Arduino UNO) y se controló la rotación del motor (motor de escobilla de carbón antiinterferencia magnética fuerte 1:48) para ejecutar las tareas de avance, retroceso y dirección del automóvil.

Medida de fuerza y características eléctricas

En el experimento de rendimiento de salida para el sensor TENG, se utilizó un motor lineal (LinMot P01-37×120-C_C1100) para cargar la presión cíclica y un dinamómetro (PUYAN DS2) para medir la presión en el experimento en tiempo real para asegurar la uniformidad de las condiciones experimentales. En este estudio, se utilizó una tarjeta de adquisición NI 9215 para recopilar datos. Se utilizó un electrómetro 6514 para medir el voltaje, la corriente y otras señales. La plataforma de software se construyó con base en LabVIEW para la adquisición, el análisis y el procesamiento en tiempo real de los datos experimentales. Se utilizó un micrófono para recoger señales de voz en tiempo real al hablar para el análisis correspondiente.

Resumen de informes

Más información sobre el diseño de la investigación está disponible en el Resumen de informes de investigación de Nature vinculado a este artículo.

Disponibilidad de datos

Todos los datos experimentales generados en este estudio están disponibles y presentados en el documento y en la Información complementaria . Los datos de origen se proporcionan con este documento.

Referencias

-

Hill J., Lillo-Martin D. y Wood S. Lenguajes de señas Estructuras y contextos , 1.ª ed. (Routledge, 2019).

-

Kim, KW, Lee, MS, Soon, BR, Ryu, MH y Kim, JN Reconocimiento del lenguaje de señas con un guante de datos basado en sensores inerciales. Tecnología Cuidado de la salud 24 , S223–S230 (2015).

-

Qian Q., et al. Sensor ultrasensible de deformación compuesto de polianilina/grafeno basado en papel para expresión en lenguaje de señas. compos. ciencia Tecnología https://doi.org/10.1016/j.compscitech.2019.05.017 (2019).

-

Zhou, Z. et al. Traducción de signos a voz utilizando conjuntos de sensores extensibles asistidos por aprendizaje automático. Nat. Electrón. 3 , 571–578 (2020).

-

Kudrinko, K., Flavin, E., Zhu, X. & Li, Q. Reconocimiento de lenguaje de señas basado en sensores portátiles: una revisión exhaustiva. IEEE Rev. Biomédica. Ing. 14 , 82–97 (2021).

-

Fernandez-Lopez, A. & Sukno, FM Encuesta sobre la lectura automática de labios en la era del aprendizaje profundo. Visibilidad de la imagen computar 78 , 53–72 (2018).

-

Lu Y., Yan J. & Gu K. Revisión de técnicas automáticas de lectura de labios. En t. J. Reconocimiento de patrones. y Artif. Intel. https://doi.org/10.1142/S0218001418560074 (2018).

-

Denby, B. et al. Interfaces de voz silenciosa. Habla Comun. 52 , 270–287 (2010).

-

Gonzalez-Lopez, JA, Gomez-Alanis, A., Martin Donas, JM, Perez-Cordoba, JL & Gomez, AM Interfaces de voz silenciosa para la restauración del habla: una revisión. Acceso IEEE 8 , 177995–178021 (2020).

-

Fagan, MJ, Ell, SR, Gilbert, JM, Sarrazin, E. & Chapman, PM Desarrollo de un sistema de reconocimiento de voz (silencioso) para pacientes después de una laringectomía. Medicina. Ing. física 30 , 419–425 (2008).

-

Gilbert, JM et al. Reconocimiento de palabras aisladas del habla silenciosa mediante implantes y sensores magnéticos. Medicina. Ing. física 32 , 1189–1197 (2010).

-

González, JA et al. Reconstrucción directa del habla a partir de datos de sensores articulatorios mediante aprendizaje automático. Trans. IEEE/ACM. Audio, Voz, Idioma. Proceso. 25 , 2362–2374 (2017).

-

Assael YM, Shillingford B., Whiteson S. y Freitas N. LipNet: lectura de labios a nivel de oración de principio a fin. arXiv https://arxiv.org/abs/1611.01599 (2016).

-

Sun K., Yu C., Shi W., Liu L. & Shi Y. El 31.er Simposio Anual de ACM sobre Software y Tecnología de Interfaz de Usuario—UIST ’18 (Asociación de Maquinaria Informática, Nueva York, 2018).

-

Hueber T., et al. (ed.) 2007 Conferencia internacional IEEE sobre acústica, voz y procesamiento de señales – ICASSP ’07. (IEEE, 2007).

-

Zhang, Y. et al. Endofasia: utilización de imágenes acústicas para emitir comandos de voz silenciosos sin contacto. En Proc. de la ACM sobre tecnologías interactivas, móviles, usables y ubicuas 1–26 (Association for Computing Machinery, Nueva York, 2020).

-

Liu H., et al. Un parche epidérmico similar a un tatuaje sEMG como una nueva interfaz hombre-máquina para pacientes con pérdida de la voz. Microsistema Nanoeng. 6 , 16 (2020).

-

Meltzner G., Colby G., Deng Y. & Heaton J. Técnicas de adquisición y procesamiento de señales para el reconocimiento de voz silencioso basado en sEMG. En: Conferencia Internacional Anual 2011 de la Sociedad de Ingeniería en Medicina y Biología del IEEE (IEEE, 2011).

-

Hinton, GE & Salakhutdinov, RR Reducción de la dimensionalidad de los datos con redes neuronales. Ciencia 313 , 504–507 (2006).

-

LeCun, Y., Bengio, Y. & Hinton, G. Aprendizaje profundo. Naturaleza 521 , 436–444 (2015).

-

Makin, JG, Moses, DA & Chang, EF Traducción automática de actividad cortical a texto con un marco codificador-decodificador. Nat. Neurosci. 23 , 575–582 (2020).

-

Sundaram, S. et al. Aprendiendo las firmas del agarre humano usando un guante táctil escalable. Naturaleza 569 , 698–702 (2019).

-

Jin, T. et al. Sensores triboeléctricos nanogeneradores para robótica blanda con el objetivo de aplicaciones de gemelos digitales. Nat. común 11 , 5381 (2020).

-

Fan, F., Tian, Z. & Wang, ZL Generador triboeléctrico flexible. Nanoenergía 1 , 328–334 (2012).

-

Zhu, G. et al. Electrodeposición de pulso impulsada por generador triboeléctrico para micropatrones. Nano Lett. 12 , 4960–4965 (2012).

-

Hinchet, R. et al. Recolección de energía de ultrasonido transcutáneo utilizando tecnología triboeléctrica capacitiva. Ciencia 365 , 491–494 (2019).

-

Wang, ZL Sobre la corriente de desplazamiento de Maxwell para energía y sensores: el origen de los nanogeneradores. Mate. Hoy 20 , 74–82 (2017).

-

Wang, ZL & Wang, AC Sobre el origen de la electrificación por contacto. Mate. Hoy 30 , 34–51 (2019).

-

Pu, X., An, S., Tang, Q., Guo, H. & Hu, C. Sensores triboeléctricos portátiles para monitoreo biomédico e interfaz hombre-máquina. iScience 24 , 102027 (2021).

-

Liu Z. et al. Nanogeneradores triboeléctricos vestibles e implantables. Adv. Función Mate. https://doi.org/10.1002/adfm.201808820 (2019).

-

Dong, K., Peng, X. & Wang, ZL Nanogeneradores piezoeléctricos y triboeléctricos basados en fibra/tejido para electrónica flexible/estirable y portátil e inteligencia artificial. Adv. Mate. 32 , e1902549 (2020).

-

Lim, G.-H. et al. Nanogeneradores triboeléctricos totalmente estirables y altamente duraderos basados en electrodos de nanoláminas de oro para detección de movimiento humano autoalimentado. Nanoenergía 42 , 300–306 (2017).

-

Wang S. et al. Nanogenerador triboeléctrico extensible y portátil basado en cinta Kinesio para detección de movimiento humano autoalimentado. Nanomateriales (Basilea) 8 , 657 (2018).

-

Zou, Y. et al. Un nanogenerador biónico estirable para detección submarina y recolección de energía. Nat. común 10 , 2695 (2019).

-

Zhang Z. et al. Calcetines inteligentes triboeléctricos habilitados para aprendizaje profundo para análisis de marcha basados en IoT y aplicaciones de realidad virtual. npj Flex. Electrón. 4 , 29 (2020).

-

Wen, F., Zhang, Z., He, T. y Lee, C. La IA permitió el reconocimiento del lenguaje de señas y la comunicación bidireccional en el espacio de RV mediante un guante inteligente triboeléctrico. Nat. común 12 , 5378 (2021).

-

Zhu, M., Sun, Z., Chen, T. & Lee, C. Manipulador de exoesqueleto de bajo costo que utiliza sensores triboeléctricos bidireccionales mejorado sistema sensorial de múltiples grados de libertad. Nat. común 12 , 2692 (2021).

-

Pu X. et al. El movimiento ocular desencadenó un sistema de comunicación mechnosensational autoalimentado utilizando un nanogenerador triboeléctrico. ciencia Adv. 3 , e1700694 (2017).

-

Qin, K. et al. Sensor de nanogenerador triboeléctrico asistido por matriz magnética para interacción de gestos en tiempo real. Nanomicro Lett. 13 , 51 (2021).

-

Vera Anaya, D., He, T., Lee, C. y Yuce, MR Sensor de movimiento ocular autoalimentado basado en interacción triboeléctrica e inducción electrostática de campo cercano para tecnologías de asistencia portátiles. Nanoenergía https://doi.org/10.1016/j.nanoen.2020.104675 (2020).

-

Zhao, Z. et al. Nanogeneradores textiles triboeléctricos lavables a máquina para una monitorización respiratoria humana eficaz mediante el tejido en telar de hilos metálicos. Adv. Mate. 28 , 10267–10274 (2016).

-

Cai, F. et al. Sensores ultrasensibles, pasivos y portátiles para monitorear el movimiento de los músculos humanos y las señales fisiológicas. Biosens. Bioelectrón. 77 , 907–913 (2016).

-

Jang, J., Lee, J., Jang, JH y Choi, H. Una membrana basilar artificial con base triboeléctrica para imitar la tonotopía coclear. Adv. Salud. Mate. 5 , 2481–2487 (2016).

-

Guo H., et al. Un sensor auditivo triboeléctrico autoalimentado de alta sensibilidad para robótica social y audífonos. ciencia Robot. 9 , eaat2516 (2018).

-

Lee, Y., Cha, SH, Kim, YW, Choi, D. & Sun, JY Comunicadores iónicos transparentes y acoplables basados en nanogeneradores triboeléctricos autolimpiables. Nat. común 9 , 1804 (2018).

-

PuX., et al. Panel táctil 3D triboeléctrico flexible con estructura de subdivisión de unidades para posicionamiento XY efectivo y detección de presión. Nanoenergía https://doi.org/10.1016/j.nanoen.2020.105047 (2020).

-

Hua, Q. et al. Redes de matriz altamente estirables y conformables inspiradas en la piel para detección multifuncional. Nat. común 9 , 244 (2018).

-

Shi, Q. et al. El aprendizaje profundo habilitó los tapetes inteligentes como un sistema de monitoreo de piso escalable. Nat. común 11 , 4609 (2020).

-

Chang S., et al. Redes neuronales recurrentes dilatadas. En: 31st Conference on Neural Information Processing Systems (NIPS 2017 ) (Curran Associates Inc, EE. UU., 2017).

-

Yang HM, Zhang XY, Yin F., Liu CL Clasificación robusta con aprendizaje de prototipo convolucional. En: Proc. Conferencia IEEE sobre visión artificial y reconocimiento de patrones 2018 . (IEEE, Ciudad del Lago, 2018).

-

Cho K., van Merrienboer B., Bahdanau D., Bengio Y. Sobre las propiedades del codificador-descodificador de traducción automática neuronal. En: Proc. SSST-8, Octavo Taller sobre Sintaxis, Semántica y Estructura en Traducción Estadística 2014 (Asociación de Lingüística Computacional, Qatar, 2014).

Agradecimientos

Este trabajo fue apoyado por la Fundación Nacional de Ciencias Naturales de China (Subvención No. 51975318, YJ Lu) y el Programa Nacional de Investigación y Desarrollo Clave de China (No. 2018YFF0300606, LH Ji). Nos gustaría agradecer al Dr. Ying Zhang por pulir todo el manuscrito y a Chao Zheng por su trabajo en los experimentos complementarios.

Información del autor

Notas del autor

- Estos autores contribuyeron por igual: Yijia Lu, Han Tian, Jia Cheng.

afiliaciones

-

State Key Laboratory of Tribology, Department of Mechanical Engineering, Tsinghua University, Beijing, 100084, China

Yijia Lu, Han Tian, Jia Cheng, Bin Liu, Shanshan Wei y Linhong Ji

-

Laboratorio Nacional de Reconocimiento de Patrones, Instituto de Automatización, Academia China de Ciencias, Beijing, 100190, China

fei zhu

-

Instituto de Nanoenergía y Nanosistemas de Beijing, Academia de Ciencias de China, Beijing, 101400, China

Zhong Lin Wang

-

Escuela de Nanociencia y Tecnología, Universidad de la Academia China de Ciencias, Beijing, 100049, China

Zhong Lin Wang

-

Escuela de Ciencia e Ingeniería de Materiales, Instituto de Tecnología de Georgia, Atlanta, GA, 30332-0245, EE. UU.

Zhong Lin Wang

Contribuciones

YL, HT y JC contribuyen igualmente a este trabajo. ZLW guió y supervisó todo el proyecto. YL y HT concibieron la idea, diseñaron los experimentos, fabricaron el dispositivo, recopilaron y analizaron los datos, generaron figuras, organizaron el contenido y redactaron el manuscrito. JC ayudó con la realización de mediciones eléctricas. FZ contribuyó con la construcción del modelo RNN dilatado, el entrenamiento y el reconocimiento de señales. BL contribuyó con el diseño y la fabricación de la puerta y el hardware del coche de juguete y la parte de control eléctrico. SW diseñó los esquemas de color y el formato de figuras unificadas. LJ contribuyó con ideas para el diseño experimental. Todos los autores discutieron los datos y prepararon el manuscrito.

Autor correspondiente

Correspondencia a Zhong Lin Wang .

Declaraciones de ética

Conflicto de intereses

YL, HT, LJ y JC son inventores en la solicitud de patente (pendiente, n.º 2020115579741) presentada por la Universidad de Tsinghua. Todos los demás autores declaran no tener intereses en competencia.

revisión por pares

Información de revisión por pares

Nature Communications agradece a Chengkuo Lee y a los otros revisores anónimos por su contribución a la revisión por pares de este trabajo.

Información adicional

Nota del editor Springer Nature se mantiene neutral con respecto a los reclamos jurisdiccionales en mapas publicados y afiliaciones institucionales.

Datos fuente

Derechos y permisos

Acceso abierto Este artículo tiene una licencia internacional Creative Commons Attribution 4.0, que permite el uso, el intercambio, la adaptación, la distribución y la reproducción en cualquier medio o formato, siempre que se otorgue el crédito correspondiente al autor o autores originales y a la fuente. proporcionar un enlace a la licencia Creative Commons e indicar si se realizaron cambios. Las imágenes u otro material de terceros en este artículo están incluidos en la licencia Creative Commons del artículo, a menos que se indique lo contrario en una línea de crédito al material. Si el material no está incluido en la licencia Creative Commons del artículo y su uso previsto no está permitido por la regulación legal o excede el uso permitido, deberá obtener el permiso directamente del titular de los derechos de autor. Para ver una copia de esta licencia, visitehttp://creativecommons.org/licenses/by/4.0/ .

Acerca de este artículo

Citar este artículo

Lu, Y., Tian, H., Cheng, J. et al. Decodificación del lenguaje labial mediante sensores triboeléctricos con aprendizaje profundo. Nat Comun 13, 1401 (2022). https://doi.org/10.1038/s41467-022-29083-0

- Recibió

- Aceptado

- Publicado

- DOIhttps://doi.org/10.1038/s41467-022-29083-0

Comparte este artículo

Cualquier persona con la que compartas el siguiente enlace podrá leer este contenido:

Proporcionado por la iniciativa de intercambio de contenido Springer Nature SharedIt

*

Compartir esto::

- Haz clic para compartir en Twitter (Se abre en una ventana nueva)

- Haz clic para compartir en Facebook (Se abre en una ventana nueva)

- Haz clic para compartir en LinkedIn (Se abre en una ventana nueva)

- Haz clic para compartir en WhatsApp (Se abre en una ventana nueva)

- Haz clic para compartir en Pinterest (Se abre en una ventana nueva)

- Haz clic para enviar un enlace por correo electrónico a un amigo (Se abre en una ventana nueva)